En un plazo similar, también tendremos Gemini 2 Ultra, LLaMA-3, Claude-3, Mistral-2 y muchos otros modelos innovadores.(El Gemini de Google ya parece estar haciendo una dura competencia al GPT-4 turbo)

Es casi seguro que GPT-5 se lanzará de forma incremental, estos serán los puntos de control intermedios durante el entrenamiento del modelo

La formación propiamente dicha puede durar 3 meses y 6 meses más para las pruebas de seguridad.

Para poner GPT-5 en perspectiva

Veamos primero las especificaciones de GPT-4:

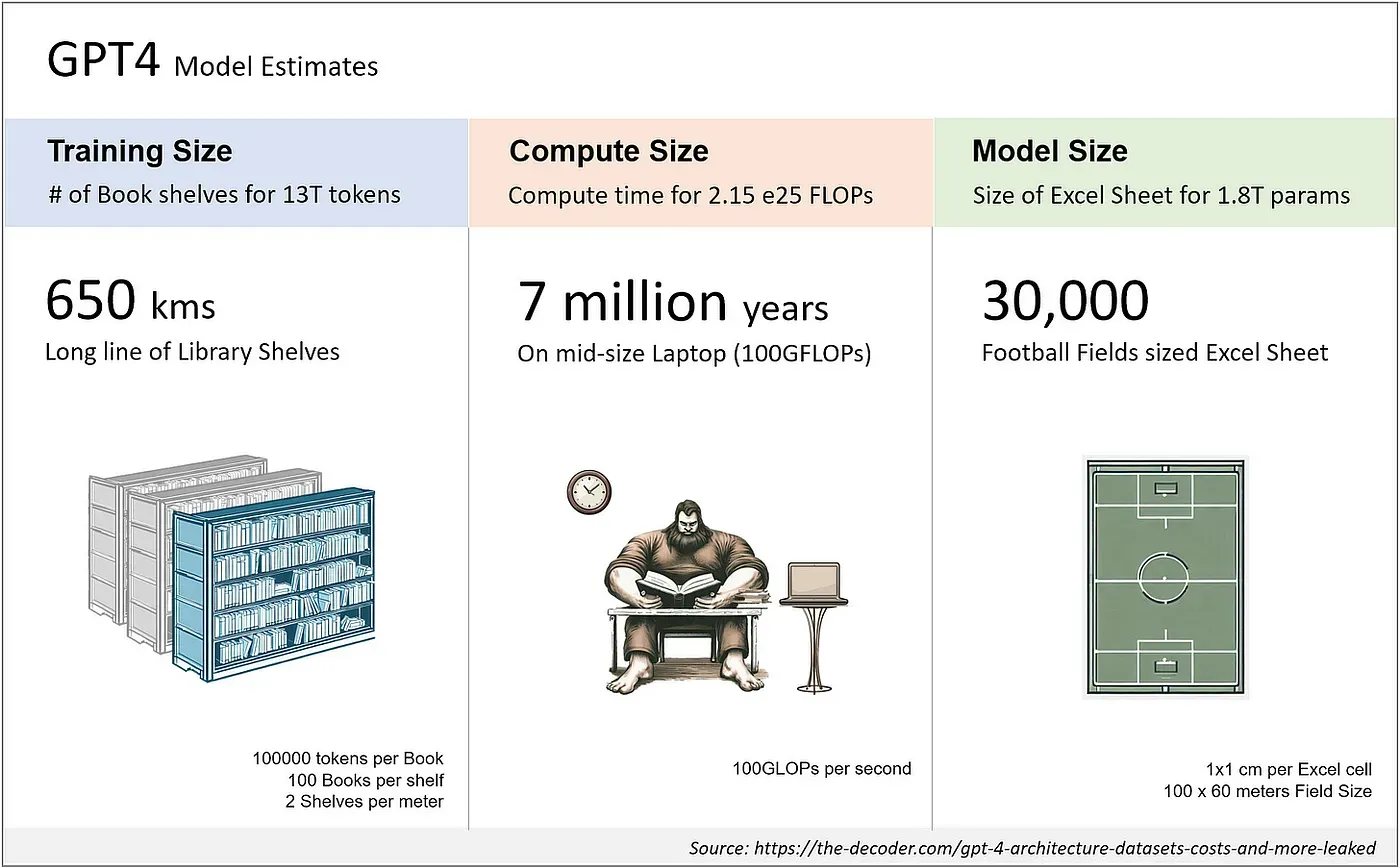

Estimaciones del modelo GPT4

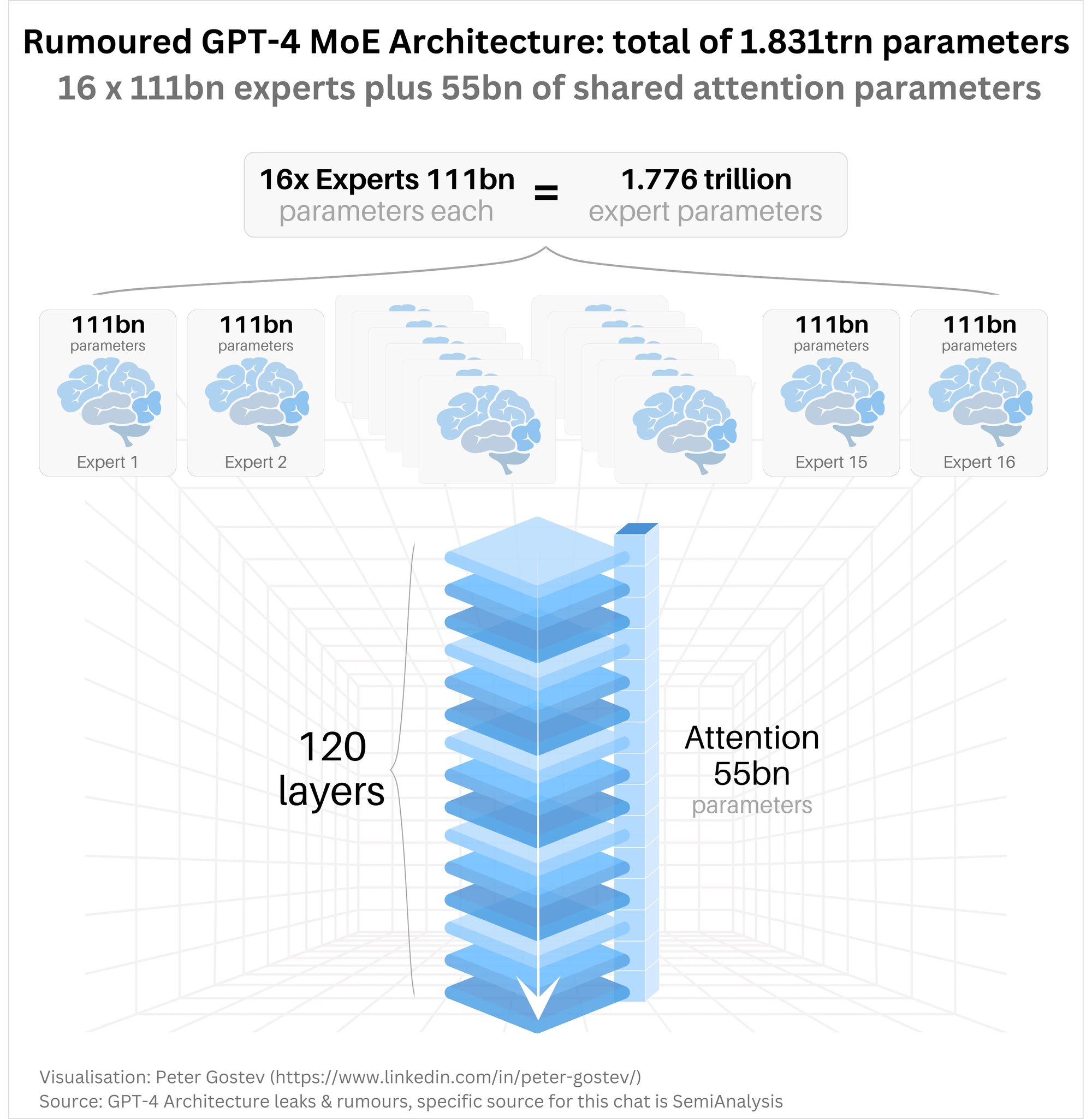

- Escala: GPT-4 tiene ~1,8 billones de parámetros en 120 capas, lo que es más de 10 veces mayor que GPT-3.

- Mezcla deexpertos: OpenAI utiliza 16 expertos en su modelo, cada uno con ~111B parámetros para MLP.

- Conjunto de datos: GPT-4 se entrena con ~13T tokens, incluyendo datos basados tanto en texto como en código, con algunos datos de ajuste de ScaleAI e internamente.

- Mezcla de conjuntos de datos: Los datos de entrenamiento incluyen CommonCrawl y RefinedWeb, con un total de 13T de tokens. Se especula con fuentes adicionales como Twitter, Reddit, YouTube y una gran colección de libros de texto.

- Coste de formación: Los costes de entrenamiento de GPT-4 rondaron los 63 millones de dólares, teniendo en cuenta la potencia de cálculo necesaria y el tiempo de entrenamiento.

- Coste de inferencia: GPT-4 cuesta 3 veces más que Davinci, con un parámetro de 175B, debido al mayor número de clusters necesarios y a los menores índices de utilización.

- Arquitectura de inferencia: La inferencia se ejecuta en un cluster de 128 GPUs, utilizando paralelismo tensorial de 8 vías y paralelismo pipeline de 16 vías.

- Visión multimodal: GPT-4 incluye un codificador de visión para que los agentes autónomos lean páginas web y transcriban imágenes y vídeos. Esto añade más parámetros por encima y se afina con otros ~2 billones de tokens.

Ahora, GPT-5 podría tener 10 veces más parámetros que GPT-4, ¡y esto es ENORME! Esto significa mayores dimensiones de incrustación, más capas y el doble de expertos.

Una mayor dimensión de incrustación significa más granularidad y duplicar el número de capas permite al modelo desarrollar un reconocimiento de patrones más profundo.

GPT-5 razonará mucho mejor, expondrá sus pasos de razonamiento antes de resolver un reto y hará que cada uno de esos pasos de razonamiento se compruebe interna o externamente.

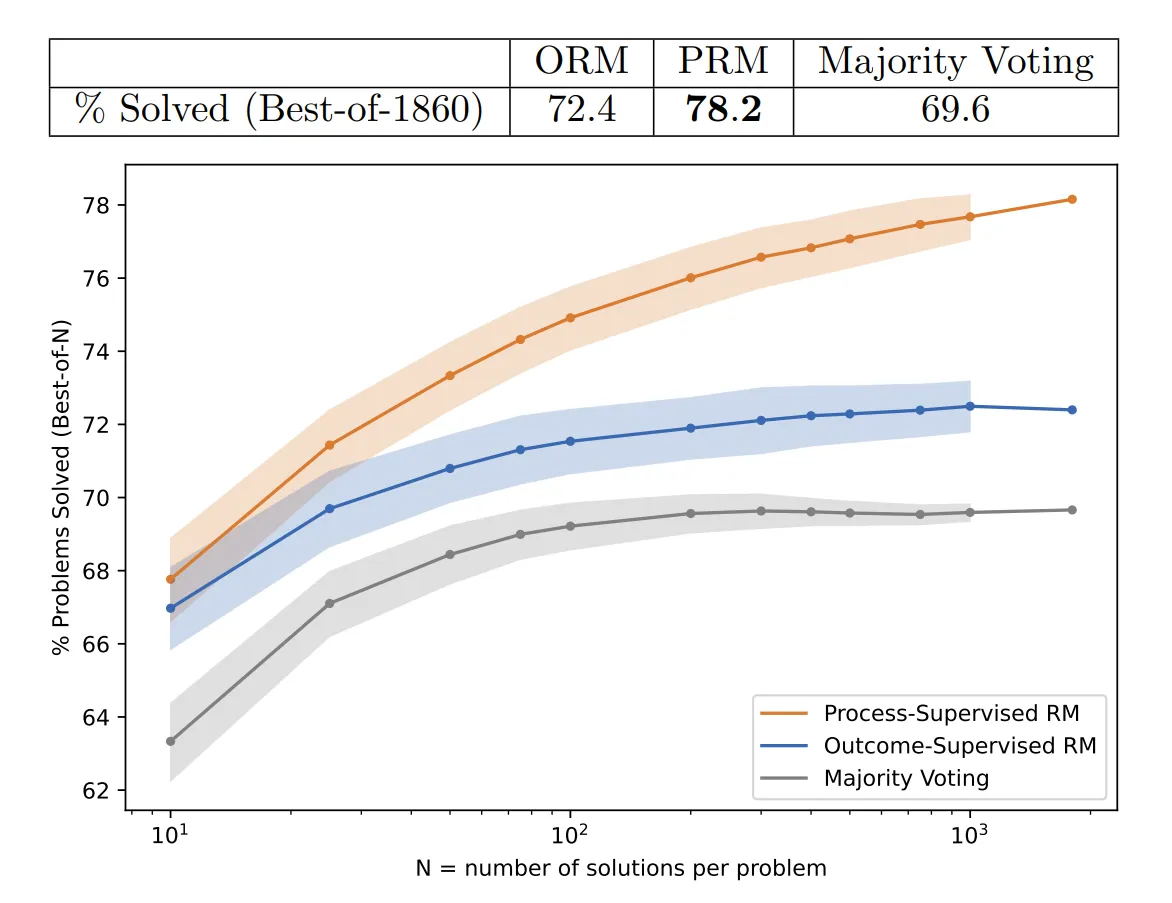

El planteamiento de verificar los pasos de razonamiento y muestrear hasta 10.000 veces conducirá a resultados espectacularmente mejores en Generación de Códigos y Matemáticas.

Comparación de modelos de recompensa supervisados por resultados y supervisados por procesos, evaluados por su capacidad para buscar entre muchas soluciones de prueba.

Si se muestrea el modelo miles de veces y se toma la respuesta con los pasos de razonamiento mejor valorados, se duplica el rendimiento en matemáticas, y no sólo en matemáticas, sino en todos los campos STEM.

GPT-5 también se entrenará con muchos más datos, tanto en términos de volumen como de calidad y diversidad.

Esto incluye cantidades ingentes de datos de texto, imagen, audio y vídeo. También datos multilingües y de razonamiento.

Esto significa que la multimodalidad mejorará mucho este año, mientras que el razonamiento LLM despegará.

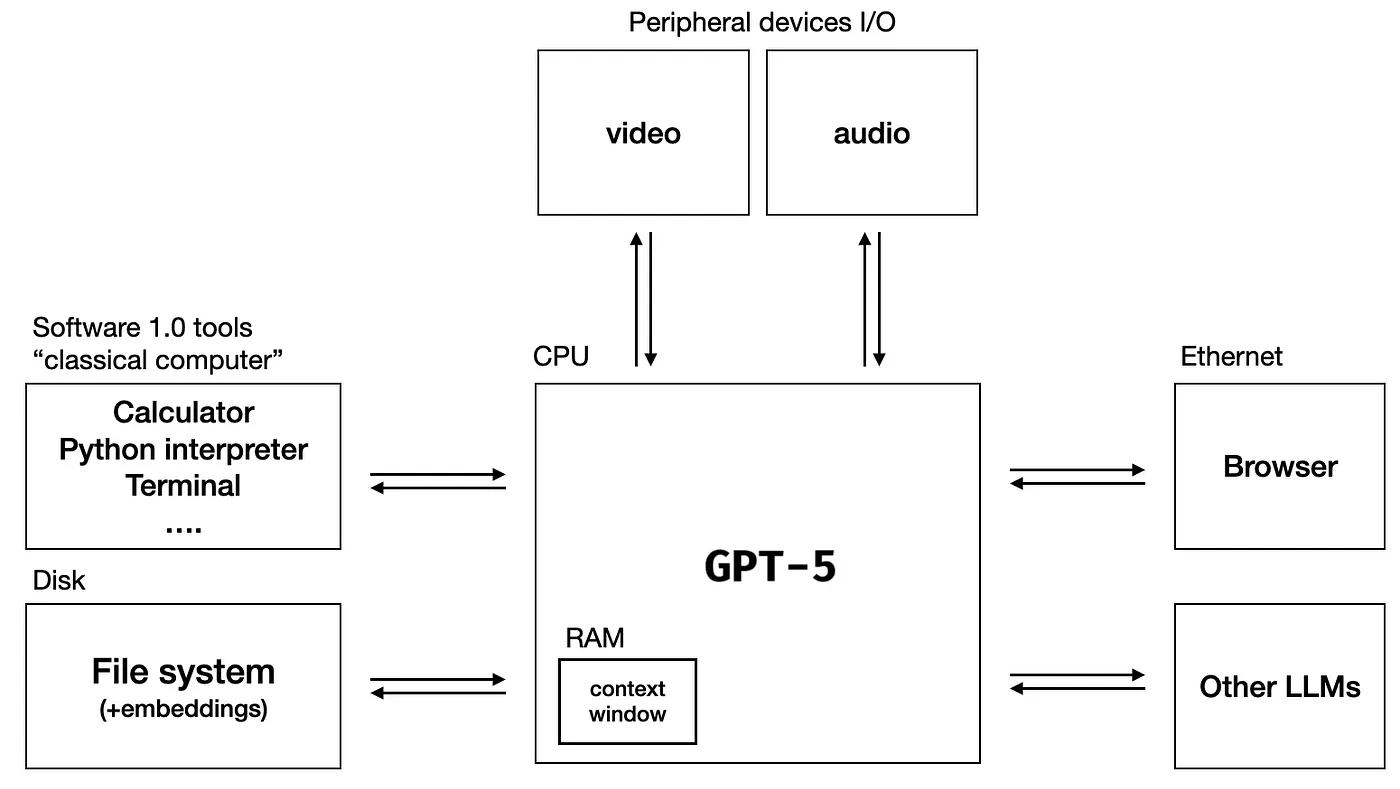

Esto hará que GPT-5 sea más ágil, igual que usar un LLM como sistema operativo.

Aunque no ocurrirá nada realmente loco/que trastoque la realidad con los LLM lanzados en 2024 como LLM inventando nueva ciencia o curando enfermedades, fabricando Esferas de Dyson o Armas Biológicas.

Nadie sabe realmente cómo serán los nuevos modelos.

El mayor tema de la historia de la IA es que está llena de sorpresas.

Cada vez que crees que sabes algo, lo multiplicas por 10 y resulta que no sabías nada. Nosotros, la Humanidad, como especie, estamos explorando esto juntos.

No obstante, todo el progreso colectivo en LLMs e IA es un paso adelante hacia la AGI🚀